Los Chatbots con Inteligencia Artificial también mienten y “alucinan”

ChatGPT, Bard (Google), el chatbot de Bing, Claude, Cohere y DALL-E, entre otros, “alucinan” cuando arrojan información inexacta, ilógica, ficticia o errónea.

La Inteligencia Artificial Generativa (IAG) es falible, es capaz de crear contenido con errores graves o que no tiene sustento en la realidad, además de que sus resultados también pueden estar sesgados, todas estas limitantes ya se han definido en este 2023 como “alucinaciones” que están presentes en las herramientas de IAG como lo son los Chatbots.

Los modelos de IAG, como ChatGPT, Bard (Google), el chatbot de Bing, Claude, Cohere y DALL-E, entre otros, “alucinan” cuando arrojan información inexacta, ilógica, ficticia o errónea, debido a que suelen presentar fallas en sus algoritmos y hasta en los datos que sirvieron para su entrenamiento.

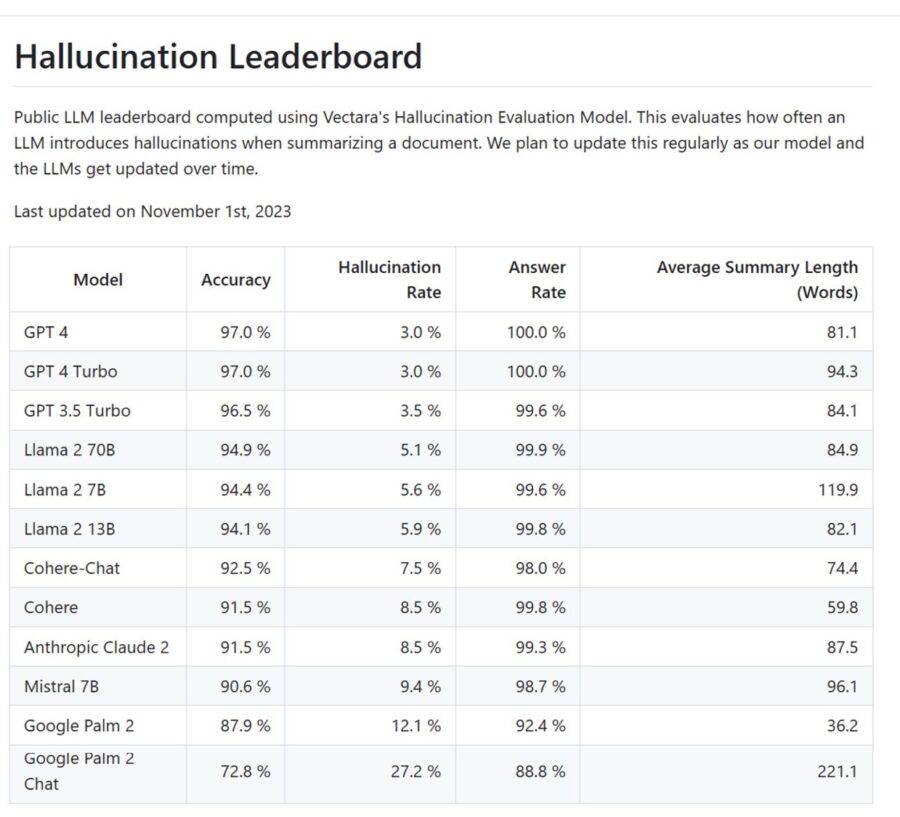

Al respecto, Vectara, una empresa fundada por exempleados de Google, ha lanzado este mes un Modelo de Evaluación de Alucinaciones (Hallucination Evaluation Model), que incluye un código abierto de medición y una tabla de clasificación, disponibles para todo el público, con los que estará calculando la precisión y calidad de los Modelos de Lenguaje Grandes (Large Language Model o LLM, por sus siglas en inglés).

El evaluador funciona asignando clasificaciones porcentuales, “lo que brinda a las empresas y desarrolladores información sobre las realidades de las diferentes herramientas” de la Inteligencia Artificial Generativa, informó la compañía. El objetivo es que las organizaciones usen -en mejores condiciones- la soluciones de la IAG, incluidos los Chatbots.

Los fundadores de Vectara, Amr Awadallah, exvicepresidente de relaciones con desarrolladores de Google Cloud; Amid Ahmad, exingeniero senior en Google Research; y Tallat Shafaat, exingeniero senior de Google Ads, consideran que el mundo de la tecnología necesita definir un estándar abierto y gratuito “en apoyo del autogobierno y la IA responsable”.

Por eso es importante conocer los riesgos que implican las “alucinaciones” de las principales plataformas de IAG. Con ello, Vectara pretende ayudar a “eliminar las barreras a la adopción empresarial (de esta tecnología), frenar peligros como la desinformación y promulgar una regulación eficaz”.

Evaluación precisa

La última actualización del Modelo de Vectara, al 1 de noviembre de 2023, reporta la exactitud (accuracy) y la tasa de alucinaciones (hallucination rate) de los 12 modelos de Inteligencia Artificial Generativa líderes en el mercado.

ChatGPT 4 es el que menos “alucinaciones” presenta con 3%, por lo que su exactitud es del 97%; a mitad de la tabla se ubica Cohere-Chat, con una tasa de “alucinación” de 7.5% y una precisión de 92.5%, mientras que la herramienta menos precisa y con más desviaciones es Google Palm 2 Chat, que muestra 72.8% de exactitud y una elevada tasa de 27.2% de “alucinaciones”.

La detección de errores, inexactitudes, y francas mentiras que en ocasiones arrojan las respuestas de la IAG es importante porque muchas de estas desviaciones suelen ser sutiles o menores, pasando desapercibidas para el usuario en general, o para aquellas personas que no son especialistas en el tema que se pregunta.

Hay que poner mucha atención en información de tipo médico o legal, pues si no se tienen esas profesiones, las “alucinaciones” de un Chatbot pueden tener consecuencias negativas si se toman decisiones a partir de lo que responde la IAG.

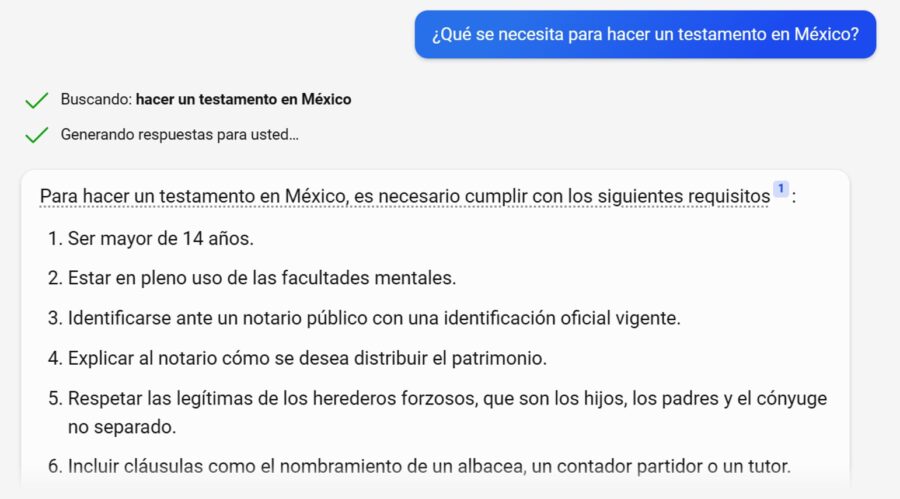

Por ejemplo, ALTO NIVEL, le preguntó al Chatbot de Bing “¿Qué se necesita para hacer un testamento en México?”. La respuesta incluyó dos errores: Se dice que entre los requisitos para realizar este documento en nuestro país están “ser mayor de 14 años”, y “respetar las (herencias) legítimas de los herederos forzosos, que son los hijos, los padres y el cónyuge no separado”.

En realidad, en México solo se puede hacer un testamento a partir de los 16 años de edad, además de que los únicos herederos forzosos son, en caso de tenerlos, los hijos menores de edad, si son mayores de 18 años es una decisión personal si el padre decide dejarles alguna herencia, y lo mismo sucede con los padres o el cónyuge.

La ventaja de Bing es que muestra las fuentes de las que ha obtenido la información para dar la respuesta, lo que permite acudir directamente a esas páginas de internet para explorar si se trata de un sitio en el que se pueda confiar.

Sin embargo, lamentablemente, en los hechos casi nadie verifica si realmente son ciertos los datos que proporciona la IAG, por lo que este tipo de “alucinaciones” no se detectan la mayoría de las veces.

Este es uno de los motivos por los que Vectara decidió crear su Modelo de Evaluación de Alucinaciones, pues con este se trata de advertir que, es factible y sobre todo muy usual, que los Chatbots respondan con datos que son inventados o “alucinados”.

Así se evita que la IAG “alucine”

En enero pasado, cuando prácticamente el mundo entero se entusiasmó con ChatGPT, creado por la empresa OpenAI, ALTO NIVEL comprobó que la herramienta arrojaba constantes errores y divergencias. Al llevar a cabo varios ejercicios se obtuvieron respuestas equivocadas y con inconsistencias, es decir, el Chatbot estaba “alucinando”.

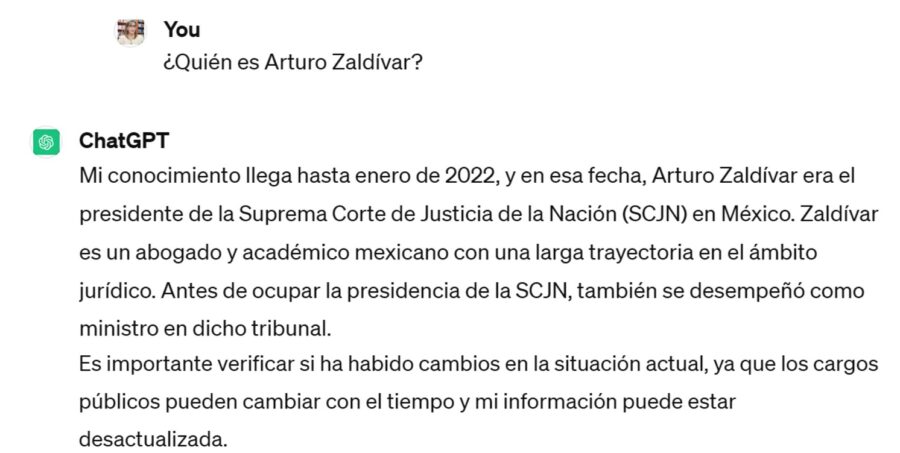

Por ejemplo, se le preguntó “¿Quién es Arturo Zaldívar?”, ChatGPT respondió: Es “actualmente presidente de la Suprema Corte de Justicia de México y ha sido magistrado de la misma desde el año 2013”.

Obviamente, el bot aún no estaba actualizado, pues Zaldívar ya no era, desde el 2 de enero de 2023, presidente de la Corte. Otro error encontrado fue que se ubicaba al jurista como miembro del máximo tribunal del país desde 2013, cuando en realidad este llegó a esa instancia en 2009.

Ahora, diez meses después, hicimos el mismo ensayo en ChatGPT, obteniendo resultados mucho más precisos. Adicionalmente, se advierte que es posible la desactualización de los datos, lo que quiere decir que la herramienta ha mejorado, sobre todo gracias a que los usuarios pueden calificar las respuestas e incluso enviar comentarios señalando las inexactitudes o errores.

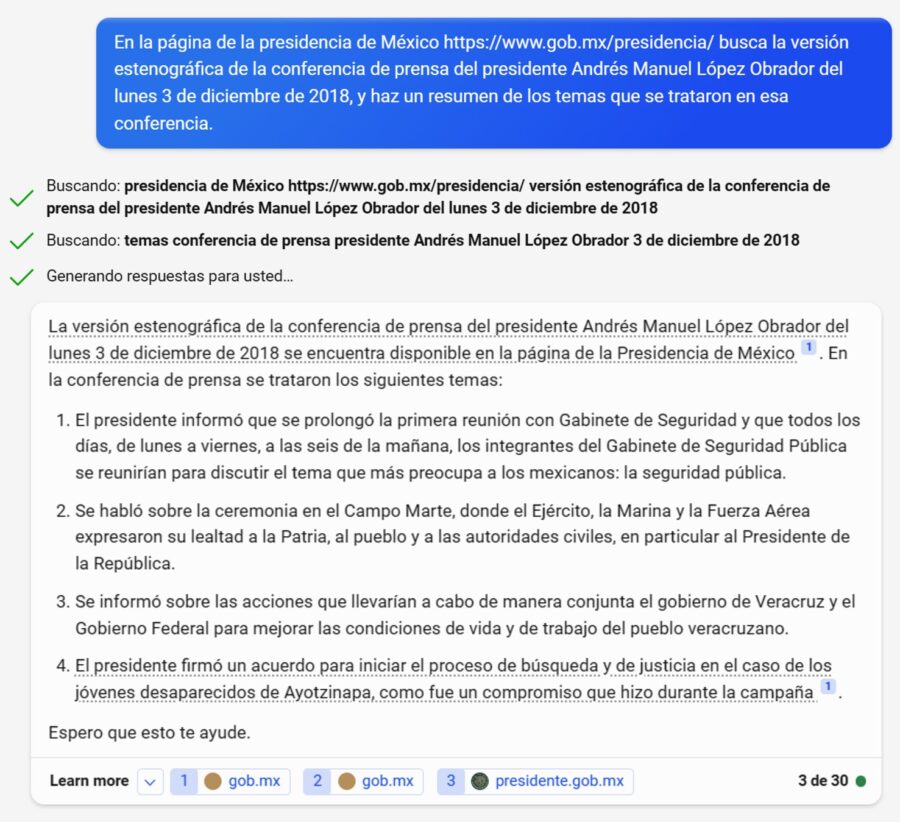

Conocer que los Chatbots “alucinan” nos permite ser mucho más cuidadosos con respecto a la información que obtenemos al utilizarlos, pero también sirve para darles indicaciones (prompts) a partir de fuentes existentes y confiables; es decir, en vez de hacer una pregunta abierta y general, hay que proporcionarle información detallada para que busque y recopile datos de una página web en específico.

Esto último no es posible hacerlo en ChatGPT, porque su versión gratuita no tiene la capacidad de buscar información en sitios web. En cambio, Bing sí lo puede realizar, y a diferencia de la consulta sobre el testamento en México, en la que este Chatbot “alucinó”, si se le dan las indicaciones adecuadas de dónde debe buscar, el resultado es correcto.

MÁS NOTICIAS:

- Profeco llama a revisión a 13 mil autos VW por falla en bolsa de aire

- ¿De vacaciones? Estos son los 5 mejores hoteles del mundo, según TripAdvisor

- Peso argentino, la moneda más ganadora frente al dólar en primer trimestre

- ¿Cuáles son los 10 países más poblados del mundo?

- Peso cierra su tercera semana con pérdidas frente al dólar